2022/11の約半年前にPCゲームをするためにグラフィックボード以外新品で組んだ。

グラボだけは中古でRTX2060(12GB)を購入した。

昨年はゲームで遊んで今年からStable diffusionやChatGPTの亜種のLLaMAなどをインストールして遊んできた。

古い世代のNvidiaのグラボだったが運よくVRAM12GBを選んだのでそこそこ生成系AIで遊べた。

最近はもう少し生成速度が欲しくなってきた。

それと動画系AIが超絶重いのでたまらない。

でもグラフィックボードはPCの中でも高額商品だ。

だからできるだけコスパがいい製品を選びたい。

ゲームは同じ土俵(ベンチマークテスト)で比較しているサイトがいくつかあるのでそこから自分に合った予算でゲームのワッパ(電力比能力)とコスパ(初期投資比性能)の高い製品を選べばいい。

しかし生成系AIだとベンチマークが国内ならアスカベンチで海外だと統一性もないので性能比較がしにくく保有しているレビュアーの感想を参考にするしかない。

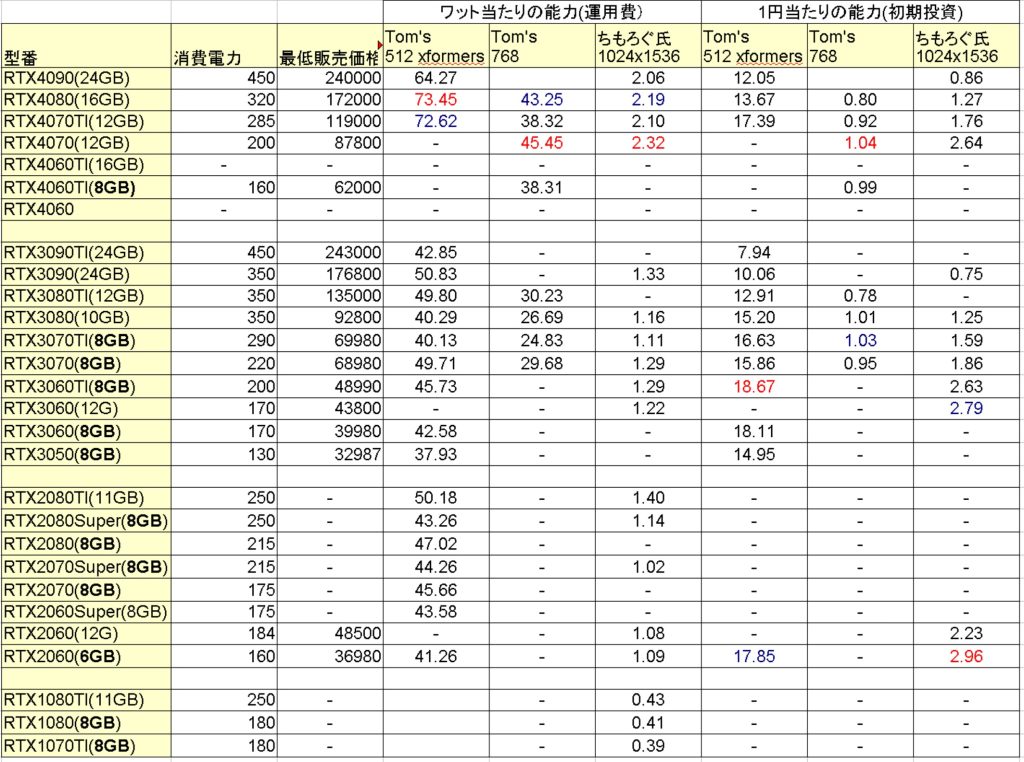

そこでできる限り数多くのグラボでStable diffusionの計測データを取っているTOM’s HardwareとちもろぐさんのStable diffusionのベンチマークからワッパとコスパで客観的にどの製品がいいのか2023/6/19時点で調査してみた。

(注意:ワッパに関してはゲームのベンチマークと異なりGPUが100%の能力を発揮した状態=最大消費電力で計測していないと想定されますのであくまで参考程度にしてください。)

TOM’sからは512×512と768×768のデータとちもろぐさんからは1024×1536の計測データを拝借して使用消費電力と2023/6/19の最安価格で割ったデータを出している。

各グラボの性能データは血と汗と涙で作った(かは知らないが)各サイトを見ていただくのが間違いない。

敢えてAI基本性能はこの表を見てもわからないようにしている。

上記表は全て数値が高い方がよりワッパ、コスパが高いと読み取っていただいて問題ない。

コスパは価格変動するためあくまで価格調査した日のものだ。

PCゲーム能力比較のようにデファクトスタンダードなベンチマークが無いため歯抜けになるのは仕方がない。

電気代がガンガン上昇しているのでもしマイニングのように1日中稼働させるとエントリーモデルのRTX3060と最上位のRTX4090では1KWh40円とすれば月に8000円の差が出て年間で10万円近い差になる。

もちろん最上位機種のRTX4090であれば能力が高いので生成できる容量が大きい。

しかしワット当たりの能力(ワットパフォーマンス=ワッパ)が低ければ電気代1円あたりに生成できる能力が低いので電気の無駄遣いとなる。

平均すると電力ピーク時間の少ないPCゲームよりもマイニングのようにグラボをぶん回して使うことが多い生成AIの方がワッパが重要になる。

言語系AIについてはベンチマークデータが見当たらなかったのでStable diffusionの計測データだけで判断するしかない。

そのAIワッパはRTX4070かRTX4080が1位、2位のようだ。

表の中では赤の数値が1位で青の数値が2位でワッパはこの2機種に集中しているのがわかる。

RTX4070(v17)はStable diffusionの性能はRTX3090より高いのに200WとRTX3060Ti並なので圧倒的だ。

各方面で生成AIエントリーお勧めになっているRTX3060(12GB)の倍近いワッパがあるというのもポイントだ。

ワッパは30シリーズより40と新しいモデルの方が高いが、20シリーズから30がそれほど高くない。

これはAI系の進化は20→30よりも30→40の方がいいのでやはりワッパを考えると今買うなら40シリーズだろう。

次は購入価格当たりの能力になるコストパフォーマンス(コスパ)で新品販売している製品だと1位はRTX2060(6GB)になる。

これはさすがにVRAMが少なすぎて論外だ。

買い替えなら最低でも8GB以上出来れば16GB欲しいところだ。

2位がRTX3060(12GB)で3位がRTX4070だ。

ワッパとコスパのどちらも優秀なのはRTX4070になる。

ただ4070の9万円近い価格は手が出しにくい。。。

とりあえず生成系AIをお安く始めたいなら誰しもが推すRTX3060(12GB)がコスパだけなら数値上でも優秀だ。

但しゲームだけで生成系AIには一切興味がないなら今はnvidiaではなくradeonから選ぶのがいい気がする。

中古で不良品を引いても交換対応できる方なら20シリーズでワッパが高めで生成AI性能がRTX3070Tiといい勝負をしているRTX2080Ti(中古5.3万円)もVRAM11GBのアドバンテージで面白いが古い製品なのでマイニング地獄を経験していそうで寿命を考えると回避が正解だ。

手持ちのRTX2060(12GB)とエントリーおすすめRTX3060(12GB)では性能差がないので自分の場合は買う意味がない。

狙うならRTX4070か、まもなく発売されるRTX4060Ti(16GB)になる。

生成AIでは学習時に大量のVRAMが必要になりCPU RAMでは肩代わりできないので積んでいる容量は多ければ処理が速いし少ないとできる事が狭くなる。

一方でゲームの場合はCUDAとVRAM間の帯域速度が影響してキャッシュサイズも絡んでくるので一概にVRAMだけが大きいよりも性能バランスが大切だがAIの場合はまずはVRAMが足りなきゃ学習で苦心するしモノによっては動作すらしない。

だからnvidiaでVRAM16GBを選ぼうとすれば最安でも17万円のRTX4080しか選択肢が無かったのでその半値で買えそうな4060Tiの16GBはそれだけ貴重な製品となる。

しかし4060Tiの16GB版は初値が8万円台中盤と当面コスパが悪そうなのでジリジリと6万円後半まで下がってくるのを待つかRTX4070がもう少し下がるのを待とう。

まあRTX2060(12GB)が壊れたわけでもないので焦ることもない。

医療費分の所得税還付金に自転車のリコール返金費用に給付金3万円に更に地方税からも還付金があるので使える臨時収入は17万円と増えた。

RTX4080を買っても予算上は大丈夫だがそこまで高性能を買ってもゲームも大してしないので宝の持ち腐れになりそうだ。

言語生成系AIも遊んでいるので本当はnvidiaに消費電力の低いRTX4060ベースで十分なのでVRAMを32GBとか48GB積んだグラボを出してくれたら17万円でも買いたい。

しかし現実はVRAMを80GB積んだA100が245万円で販売しているのでVRAM増量製品の製造はさほど難しくなくてもAIが伸びるに従って需要が上がりコスト以上に値を釣り上げる商売をするよなぁ。

32GBのLLaMA亜種のモデルをロードするにもRTX4090ですら無理なのでそこそこな言語系AIで遊ぼうと思ったら最安がA6000の64万円だ。。。

このあたりの言語モデルをCPU RAMで動かすとかなり優秀なのはわかるけどいかんせん「Hello」と打っても返事に1分かかるから使えん。

とにかくライバルのRadeon頑張れ!

なので高性能なグラボでAIを遊ぶのは諦めてワッパのいい安めのグラボを買って残りを電動アシスト自転車の更新にするか。

とりあえずRTX4060Ti16GBがリーズナブルになるのを待つのと並行して自転車の買い替えを考えよ。

先日またクルマのパンクに続き自転車がパンクして修理したばかりでどちらも焦ることはないので価格変動の様子見でいい。